本文主要包括:

- hadoop集群扩容

Hadoop集群扩容

Hadoop集群扩容可以直接在原先的节点添加磁盘,或者是添加数据节点

原有节点添加磁盘

公司集群是CDH版本,本次扩容需要在CM上操作

首先运维把扩容的磁盘挂在到3台datanode节点,具体挂在方法,咱们这里不做深究,网上很多,后期可以自己尝试一下看看

扩容机器列表:

- ddp3.hadoop

- ddp4.hadoop

- ddp5.hadoop

扩容2T磁盘存储,首先登陆到3台节点,查看磁盘空间是否已经挂载成功

可以看到,[root@h3 ~]# df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 47G 0 47G 0% /dev tmpfs 47G 8.0K 47G 1% /dev/shm tmpfs 47G 652K 47G 1% /run tmpfs 47G 0 47G 0% /sys/fs/cgroup /dev/vda1 99G 31G 64G 33% / /dev/vdb1 493G 171G 301G 37% /data cm_processes 47G 29M 47G 1% /run/cloudera-scm-agent/process tmpfs 9.3G 0 9.3G 0% /run/user/0 /dev/vdc1 2.0T 81M 1.9T 1% /mnt/data1/mnt/data1就是新添加的磁盘扩容步骤

在

/mnt/data1文件夹下创建文件夹,并赋权限cd /mnt/data1 && mkdir -p dfs/dn chown -R hdfs:hadoop dfs注意,3台节点都要创建并赋权

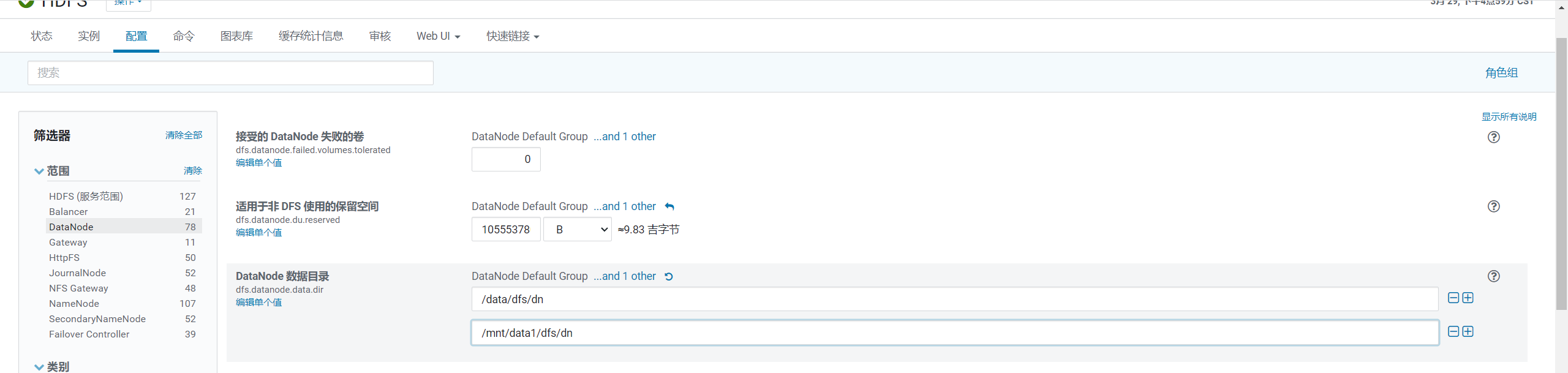

在CM管理页面上,点击HDFS -> 配置 -> DataNode ,找到

DataNode 数据目录,并新增一个数据盘,并点击保存

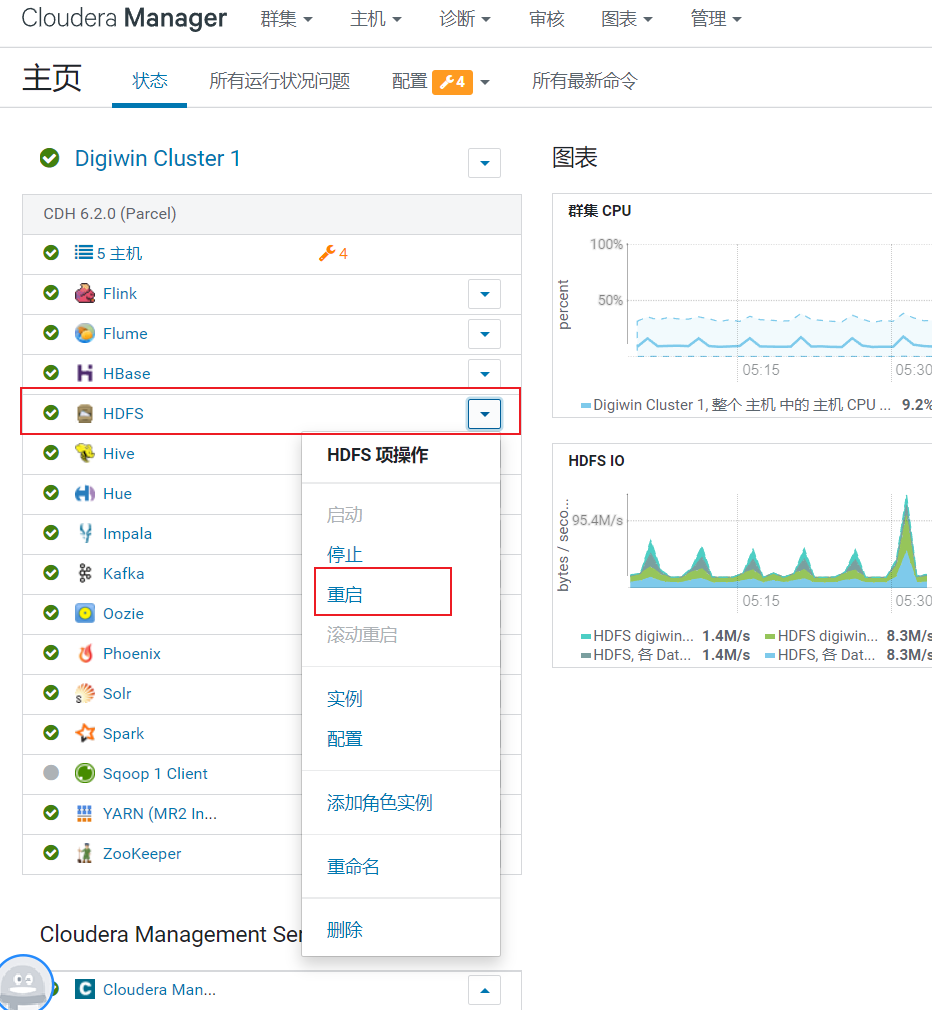

重启HDFS服务,使挂载的磁盘生效

注意集群重启过程中一定不要中止。这个过程时间可能会比较长,因为可能会有数据搬迁,会执行Balancer

4. 可以通过查看hdfs-site.xml找到datanode的日志文件路径:/var/log/hadoop-hdfs,查看datanode的执行日志

可以参考CDH(Hadoop)集群磁盘扩容

添加数据节点扩容

可以参考基于CDH6扩容